연속형 확률분포

연속형 확률분포는 이산형과는 다르게 상황이 분포를 결정짓지 못합니다. 데이터들의 형태를 보고 추측하는 정도가 전부입니다. 통계에서는 그것을 분포 가정이라고 표현하며 실질적으로 저희가 분석하는 대부분의 것들은 이 분포 가정을 통해 이루어집니다.

- 정규분포(Normal Distribution)

정규분포는 주어진 데이터의 형태가 산봉우리일 때 가정되는 분포입니다. 흔히 '종모양'에 비유하기도 합니다. 종모양이라함은 중심에 많은 데이터들이 모여있고 중심에서 멀어질수록 적은 데이터를 포함합니다. 또한 중심을 기준으로 좌우가 대칭적인 형태를 가지고 있습니다. 이는 곧 데이터의 중심과 산술적인 평균이 동일함을 의미합니다. 과거의 학자들은 많은 분야의 연속형 데이터들이 이런 형태를 띈다는 것을 발견하였고 그에 착안하여 정규분포를 고안하였습니다. 위에서 언급했던 것처럼 연속형 자료는 수집 상황이 분포를 결정하는 것이 아니고 데이터의 형태를 보고 그에 알맞는 분포를 선택한다는 것을 생각하면 지극히 상식적인 관점에서 만들어진 분포라고 생각할 수 있습니다.

그렇다면 이 산봉우리 분포는 어떤 식으로 표현될 수 있을까요. 두 가지를 이용합니다.

- 산봉우리 정상을 나타내는 '데이터의 중심' - 평균

- 산의 경사를 나타내는 '데이터의 퍼짐 정도' - 분산

평균에 따라 산은 좌우로 이동이 가능하며 분산에 따라 산의 경사가 완만한지 가파른지를 가늠할 수 있습니다. 만약 완만하다고 하면 데이터는 비교적 중심에 덜 모여 있을 것입니다. 이 경우 분산은 높다고 할 수 있습니다. 반대로 경사가 가파르다면 데이터들은 중심에서 밀도가 높고 이 경우 분산은 낮습니다.

이해를 돕기 위해 간단한 그림 하나를 보겠습니다.

위 그림을 보면 두 가지의 정규분포가 있습니다. 데이터의 중심이자 평균은 동일하고 분산은 파란색이 붉은색보다 높습니다. 그래서 산봉우리 형태의 경사가 파란색이 더 완만한 것을 볼 수 있습니다. 정규분포의 형태를 결정해주는 평균과 분산은 각각 와 로 표현합니다.

정규분포에서는 분산 의 양의 제곱근인 를 표준편차라고 부릅니다. 이 역시 데이터가 얼마나 퍼져있는지에 대한 척도로 볼 수 있습니다. 분산이 있는데도 불구하고 굳이 표준편차가 쓰이는 이유는 단위(스케일)의 문제입니다. 분산이라는 것은 실제 자료의 제곱을 이용해서 만들어집니다. 그렇기에 분산은 실제 자료에서 제곱된 단위(스케일)을 가지고 있고 양의 제곱근을 통해 구해진 는 실제 데이터들과 같은 스케일을 가지고 있습니다.

정규분포의 중요한 특징 중 하나는 정규분포를 따라는 확률변수의 선형조합 역시 정규분포를 따른다는 사실입니다. 예를 들어 평균이 10인 정규확률변수가 가정된 데이터에 모두 -10씩 해주면 그들 역시 정규분포를 따르고 평균은 0이 될 것 입니다. 같은 식으로 분산이 100인 정규확률변수가 가정된 데이터에 모두 10씩 나누어 주면 그들 역시 정규분포를 따르고 분산은 1이 됩니다. 이는 곧 중심과 단위(scale)를 자유자재로 바꾸어 줄 수 있는 유연성을 가졌다는 의미입니다.

이 성질을 이용해 정규분포 데이터의 단위를 맞추어 줄 수 있습니다. 각 데이터에서 평균을 빼고 표준편차를 나누어 주면 어떤 정규확률 변수든 평균이 0, 분산이 1인 동일한 단위를 갖게 됩니다. 이를 정규화한다고 표현하며 정규화된 분포를 표준정규분포(standard normal distribution)라고 합니다.

정규화의 실질적 의미는 각 데이터들의 단위를 제거하여 서로 다른 집단끼리도 비교할 수 있는 것입니다. 대부분의 비교 검정은 다 이런 컨셉을 근간에 두고 진행됩니다.

정규분포가 중요한 이유는 비단 많은 연속형 데이터가 정규분포를 따르기 때문만은 아닙니다. 표본들을 뽑아서 표본들의 평균을 구해보면 그것들이 따르는 분포가 정규분포이기 때문에 더욱 중요합니다. 이를 표본분포(통계량의 확률분포)라고 합니다. 이는 매우 중요한 개념이어서 여기서 집고 넘어가도록 하겠습니다.

모수(parameter)와 통계량(statistic)

모수

통계적 추론에서 분석자의 최종목표이자 모집단(population)의 특성

통계량

해당 모집단에서 추출한 표본(sample)을 이용해 만든 것으로 표본들의 함수

때로는 통계적 검정을 위해 특수한 통계량을 사용하기도 하고 모수를 추정하기 위해 통계량을 구해보기도 합니다. 전자의 경우는 검정통계량(test statistic)이라 부르고 후자의 경우는 특별히 추정량(estimator)라고 부릅니다.

간단한 예를 하나 들어 보겠습니다.

우리가 원하는 정보는 대한민국 남성의 평균 키입니다. 우리는 이것을 알아보기 위해서 무작위로 100명의 남성을 뽑아서 그들의 키를 평균 내 보았습니다.

이 경우 모집단은 대한민국 남성이며 표본은 뽑은 100명의 남자입니다. 또한 우리의 최종 목표이자 모집단의 특성인 모수는 대한민국 남성의 평균 키라고 할 수 있겠고 표본들을 통해 구한 표본들의 평균 키는 통계량이자 모수를 추정하는 추정량입니다.

또한 많은 분들이 착각하는 부분이 있는데, 통계량은 꼭 표본평균, 표본분산과 같이 모수를 추정하는 것들만이 아닙니다. 표본들의 함수는 전부 통계량입니다. 다만 표본평균과 표본분산의 경우는 다음 과 같은 함수를 이용한 것으로 아주 특수한 경우일 뿐입니다.

굳이 이런 함수가 아니더라도 표본들을 이용해서 만든 모든 값들은 통계량이라고 할 수 있습니다. 예를 들어 표본들 중 가장 큰 수, 표본 중 홀수 번째 표본만 더한 값 등도 사용할 일은 별로 없을 수 있지만 하나의 통계량입니다.

표본분포(Sample Distribution)

표본분포를 한 마다로 정리하면 통계량의 확률분포입니다. 모집단이 어떤 특정한 분포를 따르고 있을 때 n개의 표본을 추출했다면 그 표본들은 모집단의 확률분포에 기반하여 추출된 것이라고 할 수 있습니다. 이 관점으로 보면 표본들은 확률표본(random sample)이고 통계량은 그 표본들의 함수이므로 당연히 특정한 확률 구조를 갖는 확률변수로 볼 수 있습니다. 이 통계량의 확률 구조를 표본분포라고 합니다.

만약 모집단이 평균이 고 분산이 인 정규분포를 따른다고 합시다. 그리고 거기서 n개의 표본을 뽑았다고 하면 표본평균 는 정규확률샘플들의 선형 결합이고 이는 위에서 언급한 정규분포의 특성으로 인해 정규분포를 따를 것입니다. 구체적으로 보면 다음과 같은 정규분포를 따릅니다.

모집단의 분포가 라면,

이것이 라는 통계량의 확률분포, 즉, 표본분포입니다. 말고도 다른 통계량들도 각자 마다의 특정한 확률구조를 가지고 있습니다. 그렇지만 우리는 까지만 알고 가겠습니다.

재밌는 것은 표본 수 n이 어느정도 큰 상황이면 굳이 모집단이 정규분포를 따르지 않다고 하여도 표본평균은 위와 같은 정규분포를 근사적으로 따르게 됩니다. 이를 중심극한정리(Central Limit Theorem, CLT)라고 하며 모든 통계 검정의 근간이 됩니다. 이 중심극한정리 때문에 정규분포는 모든 분포 중에서 가장 중요한 분포로 취급 받습니다. 모집단이 어떤 분포여도, 심지어 우리가 절대 일반화할 수 없는 매우 복잡한 확률구조를 갖고있어도 표본평균의 분포는 정규분포로 통일되기 때문이죠.

이는 다음과 같이 표현할 수 있습니다.

xxxxxxxxxxlibrary(ggplot2)K = c(10, 100, 1000, 10000, 100000)for(k in K){ PROB_LIST = c( ) for( i in 1:k){ BI = sample(c("H","T"),size = 200, replace = TRUE, prob = c(0.5,0.5)) PROB = ifelse(BI == "H" , 1, 0 ) PROB = sum(PROB) / 200 PROB_LIST = c(PROB_LIST, PROB) } CLT = data.frame(PROB = PROB_LIST) graph = ggplot(CLT,aes(x = PROB)) + geom_bar(fill = 'royalblue', alpha = 0.3) ggsave(file = paste("C:/R/",k,'.jpg',sep=""))}보시는 것과 같이 표본평균의 분포는 횟수가 많아질수록, 정규분포에 근사해지는 것을 알 수 있습니다. 이로써, 모집단의 분포와 상관 없이 평균이 이고 분산이 라면,

이는 표본평균이 '근사적으로 ' 정규분포를 따른다는 것입니다. 이는 n이 커질수록 더욱 정확히 따른다는 뜻을 내포하고 있기도 합니다. 이 부분은 매우 중요한 부분이니 꼭 기억하고 가시기 바랍니다.

- t-분포(t-distribution, Student's t-distribution)

t분포를 이해하려면 우선 t분포라는 분포가 왜 고안되었는지에 대해 알아야 합니다. t분포는 순전히 평균이 같은지 다른지 검정을 하기 위해 만들어졌습니다.

위에서 언급하길 만약 모집단이 정규분포르 따른다고 하면 표본들의 평균인 표본평균은 을 따른다고 하였습니다. 그래서 과거에는 이를 이용하여 평균 검정을 해왔는데, 일반적으로 우리는 모분산인 를 알 길이 없습니다. 만약 n이 매우 크다면 더욱 정확히 정규분포를 따를 것이고 표본평균의 분산 역시 0으로 점차 수렴하여 사실상 의 영향이 미미할테니 상관 없지만 문제는 표본 수가 작을 때입니다. 이때는 분산을 정확히 알 수 없어 정규분포를 이용한 검정이 그 신뢰성을 잃게됩니다.

이런 경우의 검정을 위해 표준정규분포를 이용하여 정규분포와 형태는 비슷하지만 모분산 항을 포함하고 있지 않고 그 모분산 대신 표분분산을 이용한 분포를 고안해 내는데, 그것이 t분포입니다.

t분포는 정규분포와 같이 중심을 기준으로 좌우 대칭이고 종모양의 형태를 갖고 중심은 0으로 고정되어있습니다. 즉, 위에서 다룬 표준정규분포와 중심이 같고 자유도(degree of freedom, df)에 따라 종의 형태가 조금씩 변화합니다. df는 표본 수와 관련이 있는 개념으로, 표본이 많아지면 표준정규분포와 거의 동일한 형태를 보입니다.

우선 t분포의 확률함수를 보고 가겠습니다.

t분포의 또 다른 특징은 표본 수가 적으면 적을수록 표준정규분포에 비해 양쪽 꼬리가 더 두텁다는 것입니다. 이는 데이터들이 그만큼 중심에 덜 모여있다는 뜻이기도 하고 검정의 관점으로 보면 조금 더 관대하다는 뜻입니다. 정규분포를 이용한 검정의 경우는 중심에서 비교적 조금만 벗어나도 다르다는 결과를 보이지만 t분포는 정규분포에 비해 상대적으로 더 벗어나도 같다는 결과를 줍니다.

이는 표본 수가 적은데서 나오는 우연에 의한 극단적인 값에 대해서도 어느정도 유연한 검정 결과를 준다고 할 수 있습니다.

물론 이 역시 표본이 적을 때의 경우이고 표본이 많아진다면 표준정규분포와 거의 동일한 결과를 보입니다. 극단적으로 표본이 무한에 가까워진다면 t분포는 표준정규분포와 동일한 확률 구조를 갖게될 것입니다.

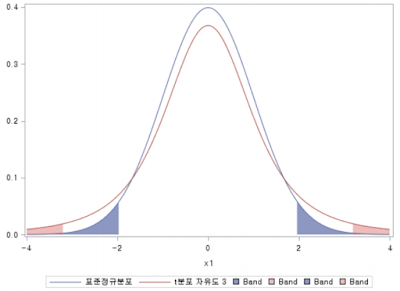

아래 그림은 표준정규분포와 t분포의 차이를 보여주는 그림으로 t분포의 경우 자유도가 3인 경우입니다.

각 그래프의 색칠한 부분은 좌우 각각 데이터의 2.5% 씩, 합쳐서 5%의 영역입니다. 위 그림에서 확인할 수 있듯이 표준정규분포 보다는 t분포가 훨씬 더 중심에서 많이 퍼져있음을 볼 수 있습니다. 만약 이대로 검정을 하게 된다면 표준정규분포의 경우 중심과 2정도가 차이나면 다르다는 결과를 주겠지만 t분포의 경우는 중심과 3이 차이난다고 하여도 같다는 결과를 줄 것입니다. 이와 같은 결과를 '보수적이다' 혹은 '보수적인 검정이다' 라고 표현하는데 웬만큼 확신이 없으면 다르다는 결과를 주지 않기 때문에 그렇게 불립니다.

즉, 평균에 대한 검정에 한해서는 표준정규분포를 이용한 검정보다 t분포를 이용한 검정이 더 보수적인 접근방법이라고 할 수 있겠습니다.